Raspberry Pi AI HAT+ 2: KI-Modelle jetzt offline auf dem Mini-Computer

17.01.2026 - 21:35:12

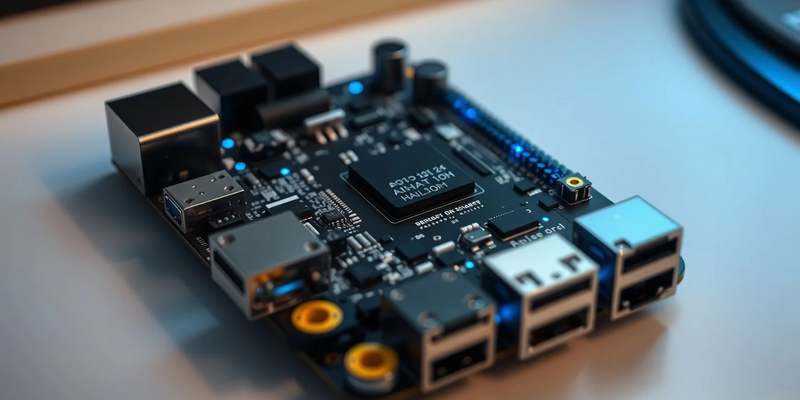

Der Raspberry Pi 5 erhält mit dem AI HAT+ 2 ein Hardware-Upgrade, das große Sprachmodelle erstmals lokal und ohne Cloud ausführt. Das 130 Euro teure Zusatzmodul adressiert den wachsenden Bedarf an privater, schneller und kostengünstiger KI-Verarbeitung direkt auf dem Gerät – ein Meilenstein für Edge-Computing.

Hardware-Kern: Hailo-10H mit eigenem Arbeitsspeicher

Das Herzstück des neuen AI HAT+ 2 ist der Hailo-10H-Beschleunigerchip. Er liefert eine Rechenleistung von 40 TOPS (Tera-Operations pro Sekunde) und ist damit für anspruchsvolle generative KI-Modelle ausgelegt. Die entscheidende Neuerung: 8 GB dedizierter LPDDR4-Arbeitsspeicher, der ausschließlich dem KI-Beschleuniger zur Verfügung steht.

Diese Architektur ist der Schlüssel zum Erfolg. Die KI-Modelle laufen, ohne den Haupt-Arbeitsspeicher des Raspberry Pi 5 zu belasten. Der Mini-Computer bleibt für andere Aufgaben frei, was die Gesamtleistung deutlich steigert. Erst dieser eigene Speicher ermöglicht das Ausführen größerer Modelle wie LLMs (Large Language Models), was frühere Versionen limitierte. Das Board erfüllt die offizielle HAT+-Spezifikation und verbindet sich über PCI Express mit dem Raspberry Pi 5, wo es vom aktuellen Betriebssystem automatisch erkannt wird.

Passend zum Thema lokale KI-Modelle: Seit August 2024 gelten neue EU‑Vorgaben zur Nutzung und Kennzeichnung von KI‑Systemen – viele Entwickler und Anbieter sind noch unsicher, was das konkret bedeutet. Der kostenlose Leitfaden zur EU‑KI‑Verordnung erklärt Risikoklassen, Dokumentationspflichten und Kennzeichnungspflichten praxisnah, damit Sie Ihr On‑Device‑KI‑Projekt rechtssicher einordnen und absichern können. Enthalten sind praktische Checklisten, Beispiele für notwendige Dokumentationen und Hinweise zu Übergangsfristen. Jetzt KI-Leitfaden herunterladen

Vom Bilderkennen zum Texterstellen: Ein Quantensprung

Der Vorgänger, der im Oktober 2024 vorgestellte erste AI HAT+, war mit Hailo-8-Chips und bis zu 26 TOPS vor allem für klassische Computer-Vision-Aufgaben wie Objekterkennung konzipiert. Für den speicherhungrigen Betrieb von Sprachmodellen war er nicht ausgelegt.

Genau diese Lücke schließt der AI HAT+ 2. Seine Stärke liegt nicht in gesteigerter Vision-Leistung, sondern in den neuen generativen Fähigkeiten. Zum Start unterstützt die Hardware mehrere vorinstallierte Modelle, darunter DeepSeek-R1-Distill (1,5 Mrd. Parameter) und Llama3.2 (1 Mrd. Parameter). Entwickler können damit direkt auf dem Gerät Anwendungen für Spracherkennung, Übersetzung oder Bildanalyse erstellen. Die notwendige Software und Beispielmodelle stellt Hailo über ein GitHub-Repository bereit.

Einfache Integration für praktische Anwendungen

Raspberry Pi legt Wert auf nahtlose Integration in die bestehende Software-Welt. Der AI HAT+ 2 arbeitet mit den nativen rpicam-apps zusammen. Kompatible Nachbearbeitungsaufgaben werden automatisch auf den Hailo-Beschleuniger ausgelagert – ohne zusätzliche Konfiguration. Diese Benutzerfreundlichkeit soll sowohl Bestandskunden als auch Neueinsteiger überzeugen.

Die Technologie eröffnet zahlreiche Anwendungsszenarien, in denen Datenschutz, geringe Latenz und Netzunabhängigkeit entscheidend sind. Denkbar sind industrielle Prozesssteuerung ohne Internet, sichere Gebäudemanagement-Systeme mit lokaler Datenverarbeitung oder Echtzeit-Entscheidungen in der Robotik. Indem teure Cloud-API-Abonnements entfallen, bietet das Modul einen kosteneffizienten Weg zu anspruchsvollen KI-Lösungen.

Marktpositionierung: Raspberry Pi als Edge-AI-Treiber

Mit dem AI HAT+ 2 positioniert sich Raspberry Pi klar im wachsenden Markt für Edge-KI. Die lokal lauffähigen Modelle sind zwar kleiner als cloud-basierte Giganten wie ChatGPT, aber für eine Vielzahl spezialisierter Offline-Aufgaben leistungsstark genug. Der Launch reagiert direkt auf die Nachfrage von Entwicklern nach Werkzeugen für private, lokale KI.

Der dedizierte Arbeitsspeicher ist dabei ein entscheidender Unterschied zu vielen kostengünstigen Konkurrenzprodukten. Er beseitigt den primären Engpass für generative Modelle auf kompakten Geräten. Mit einer komplett integrierten Lösung unter 150 Euro senkt Raspberry Pi die Einstiegshürde für experimentierfreudige Entwickler und praktische Anwendungen am Netzwerkrand erheblich.

Die erweiterten On-Device-KI-Fähigkeiten dürften eine neue Welle kreativer Projekte und industrieller Lösungen befeuern. Damit festigt der Mini-Computer einmal mehr seine Rolle als führende Plattform für hochperformantes, erschwingliches Computing.

PS: Wenn Sie lokale Modelle wie Llama3.2 oder DeepSeek auf Edge‑Geräten einsetzen, sollten Sie die Umsetzungsanforderungen der EU‑KI‑Verordnung kennen. Das kostenlose E‑Book liefert einen kompakten Umsetzungsleitfaden mit konkreten Schritten zur Klassifizierung, Risikominderung und Dokumentation für Entwickler und Unternehmen. Es richtet sich an Entwickler, Hersteller und Integratoren, die KI‑Komponenten lokal betreiben und dabei rechtssicher bleiben wollen. KI-Umsetzungsleitfaden jetzt sichern