DeepSeek: Neue KI-Architektur Engram könnte Hardware-Kosten halbieren

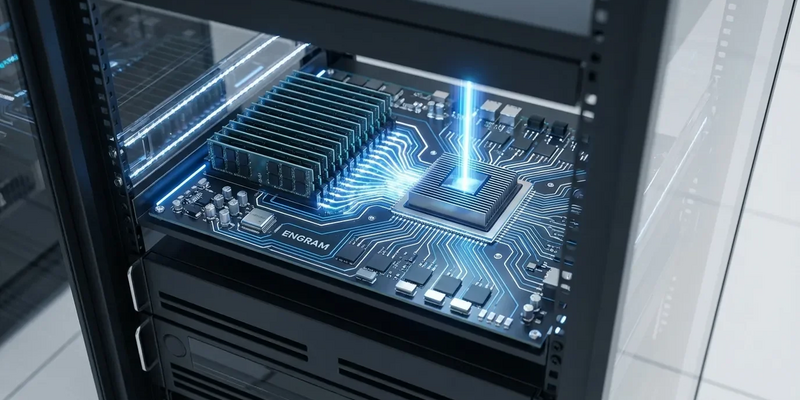

14.01.2026 - 21:30:12Ein chinesischer KI-Pionier stellt mit einer neuartigen Speichertechnik die Wirtschaftlichkeit großer Sprachmodelle auf den Kopf. DeepSeek hat mit „Engram“ eine Architektur entwickelt, die den teuren Hunger nach Hochleistungs-Hardware drastisch reduzieren könnte.

Die als „Conditional Memory“ bezeichnete Technik attackiert eines der größten Hindernisse beim KI-Skalieren: den begrenzten Speicher selbst modernster Grafikprozessoren (GPUs). Indem Engram das statische Faktenwissen einer KI von ihren aktiven Denkprozessen trennt, könnten riesige Modelle plötzlich auf günstigerer Hardware laufen. Das hätte tiefgreifende Folgen für eine Branche, die mit Lieferengpässen und explodierenden Rechenkosten kämpft. Die Forschung von DeepSeek-Gründer Liang Wenfeng und der Peking-Universität ist öffentlich zugänglich – inklusive Quellcode.

Der Kern des Durchbruchs liegt in der Trennung von Logik und Wissen. Bisher nutzen KI-Modelle dieselben teuren Rechenressourcen für alles – vom komplexen Schlussfolgern bis zum Abruf simpler Fakten. Eine immense Verschwendung von Prozessorleistung für triviale Aufgaben, wie Forscher kritisieren.

Engram schafft ein effizientes Archivsystem. Es lagert statisches Wissen – statistische Wortfolgen und Fakten, sogenannte N-Grams – in eine abfragbare Wissensdatenbank aus. Diese kann in gängigem und günstigem Arbeitsspeicher (DRAM) liegen, statt im knappen und teuren High-Bandwidth Memory (HBM) direkt auf der GPU. Das elite HBM und die Rechenkerne der GPU werden so für die eigentliche Schwerarbeit freigespielt: das Denken und Problemlösen. Die KI kann Grundfakten quasi „nachschlagen“, anstatt sie bei jeder Abfrage neu „berechnen“ zu müssen.

Passend zum Thema KI-Entwicklung: Seit August 2024 gelten neue Regeln für KI‑Systeme in der EU, die Entwickler, Anbieter und Betreiber vor konkrete Pflichten stellen. Dieses kostenlose E‑Book zur EU‑KI‑Verordnung erklärt kompakt Kennzeichnungspflichten, Risikoklassifizierung, notwendige Dokumentationsanforderungen und Übergangsfristen. Praxisnahe Checklisten zeigen, wie Sie Ihr System korrekt einordnen und die erforderliche Dokumentation aufsetzen, damit Sie neue Modelle sicher und rechtssicher kommerzialisieren können. Jetzt kostenlosen KI-Umsetzungsleitfaden herunterladen

Deutliche Leistungssteigerungen belegt

Die versprochenen Effizienzgewinne sind nicht nur Theorie. DeepSeek testete ein 27-Milliarden-Parameter-Modell mit Engram gegen ein gleich großes Standard-Modell. Die Ergebnisse überzeugten.

Das Engram-Modell zeigte in wissensintensiven Aufgaben eine 3,4 bis 4 Punkte höhere Leistung. Noch bemerkenswerter: Es verbesserte sich auch beim logischen Schlussfolgern um 3,7 bis 5 Punkte. Das legt nahe, dass freigewordene Rechenleistung das Kerndenken der KI verbessert. Ähnliche Sprünge gab es bei Codier- und Mathetests. Zudem hilft die Technik, lange Eingabetexte besser zu verarbeiten – ein Dauerthema namens „Long Context“. Das ebnet den Weg für fähigere KI-Assistenten in langen Gesprächen.

Innovation trotz Hardware-Beschränkungen

Die Entwicklung ist hochaktuell vor dem geopolitischen Hintergrund. US-Exportkontrollen beschränken den Zugang chinesischer Firmen zu modernsten KI‑Chips und dem benötigten HBM. Indem DeepSeek eine Methode entwickelt, die diese Abhängigkeit verringert, zeigt es einen Innovationspfad mit verfügbarer Hardware auf. Diese Strategie, sich an Beschränkungen „vorbeizuinnovieren“, wird global aufmerksam verfolgt.

Branchenbeobachter spekulieren: Würde Engram breit adaptiert, könnte das Server-Architekturen verändern. Die Nachfrage könnte weg von Systemen mit massiv gekoppeltem HBM hin zu entkoppelten Designs gehen. Technologien wie Compute Express Link (CXL) könnten große Pools günstigen Speichers mit Recheneinheiten verbinden. Diese Entkopplung von Speicher- und Rechenkosten könnte die finanzielle Hürde für das Training großer KI massiv senken.

Ein Grundbaustein für die nächste KI-Generation?

Die Forscher sehen Conditional Memory als unverzichtbaren Grundbaustein für die nächste Generation „sparser“ Modelle. Das Timing der Veröffentlichung ist kein Zufall: Gerüchten zufolge bereitet DeepSeek den Start eines neuen Modells in den kommenden Wochen vor – womöglich die erste kommerzielle Anwendung der Engram-Architektur.

Die vielversprechenden Ergebnisse müssen nun den harten Review der globalen Forschungsgemeinschaft bestehen. Der echte Impact wird sich in der Praxis und der Adaptionsrate zeigen. Nach seiner einflussreichen Arbeit an Mixture-of-Experts-Modellen positioniert sich DeepSeek mit diesem Durchbruch erneut als Schlüssel-Innovator im kritischen Feld der KI-Effizienz und Hardware-Optimierung.

PS: Die Umsetzungsfristen der EU‑KI‑Verordnung laufen – ist Ihr Team bereit, die Anforderungen zu erfüllen? Der kostenlose Leitfaden zeigt Schritt für Schritt, wie Sie Modelle korrekt klassifizieren, notwendige Dokumentation digital ablegen und Kennzeichnungspflichten erfüllen. Mit praktischen Vorlagen für Entwickler und Compliance‑Verantwortliche ist er besonders nützlich für Unternehmen, die Engram‑ähnliche Technologien kommerziell einsetzen oder in ihre Produktprozesse integrieren wollen. Kostenloses E-Book zur EU-KI-Verordnung jetzt herunterladen